打造一个 AI 大模型,需要多少算力?

广发证券认为,在暂不考虑软件层面算法优化带来的模型消耗算力成本下降的前提下,国内大模型在训练与推理阶段或将产生相当于 1.1 万台或 3.8 万台(乐观假设下)高端 AI 服务器的算力需求,以单片 A100 售价 10 万元人民币、AI 加速卡价值量占服务器整机约 70% 计算,则对应约 126 亿元(人民币)或 434 亿元增量 AI 服务器市场规模。

在席卷全球的 AI 热潮中,一个不容忽视的潜在阻力是算力的不足。算力是 AI 发展的基础设施,AI 训练需要将数据集进行重复多轮处理,算力的大小代表着对数据处理能力的强弱。

据 OpenAI 测算,2012 年开始,全球 AI 训练所用的计算量呈现指数增长,平均每 3.43 个月便会翻一倍,目前计算量已扩大 30 万倍,远超算力增长速度。随着百度、360、华为等公司纷纷入局 AI 领域,国内厂商对算力的需求将迎来井喷。

综合 OpenAI 的研究经验,以及中国企业大模型的研发进度等因素,广发证券分析师刘雪峰等对国内 AI 大模型的训练和推理阶段算力需求,以及相应的成本进行了测算。

算力需求

首先,分析师根据 GPT-3 的数据测算了国内 AI 大模型训练和推理所需的 AI 服务器需求。

分析师认为:

根据商汤招股说明书的数据,GPT-3 的大模型的所需要训练 355 个 GPU-年。在当前各家公司推出 AI 大模型意愿较强的背景下,我们认为科技公司用于训练 AI 大模型的时间为 1 个月,因此其需要训练 AI 大模型的 AI 加速卡的数量为 4260 个。

我们认为,AI 大模型有望成为各科技厂商竞争的关键领域,因此假设国内有意愿开发 AI 大模型的公司有 10 个,则由于 AI 大模型训练而新增的 AI 加速卡需求空间为 4.3 万个,国内由于 AI 大模型训练而新增的 AI 服务器的需求空间约为 5325 台(本文均假设单台 AI 服务器搭载 8 个 AI 加速卡)。

根据英伟达官网的数据,A100 针对于 BERT 类的 AI 大模型可实现每秒推理 1757 次,因此可假设单片 A100 用于 AI 大模型每秒生成 1757 个单词,与单次客户需要生成的内容数量相当。

截止 2023 年 3 月 27 日,百度 “文心一言” 已收到 12 万家企业申请测试。我们预计,国产 “类 ChatGPT” 的访客量规模较为庞大。

2023 年 3 月 29 日,在 “2023 数字安全与发展高峰论坛” 上,三六零公司现场演示了 360 大语言模型在 360 浏览器上的应用。分析师认为,内容生成类应用已成为各科技厂商开发 AI 大模型积极探索的方向,因此假设国内未来开发并应用 “类 ChatGPT” AI 大模型的数量为 10 个。针对不同情境分析师进行了以下假设:

- 国产 “类 ChatGPT” 的定位是仅给注册企业内部使用,则假设每天访问量为 5000 万人次,每人与 ChatGPT 对话 5 次,由此测算下来,由于 AI 大模型推理而新增的 AI 加速卡需求空间为 4.3 万个,新增的 AI 服务器需求空间为 5425 台。

- 国产 “类 ChatGPT” 的定位是面向个人用户开放使用,则分别假设每天访问量为 1 亿或 3 亿人次,每人与 ChatGPT 对话 5 次,由此测算下来,由于 AI 大模型推理而新增的 AI 加速卡需求空间为 8.7 万或 26.0 万个,新增的 AI 服务器需求空间为 1.1 万或 3.3 万台。

因此,乐观假设下,国内 AI 大模型在训练与推理阶段或将产生相当于 1.1 万台或 3.8 万台高端 AI 服务器的算力需求。

成本测算

此外,分析师强调,多模态大模型是 AI 大模型的发展方向,应用前景广阔。今年以来,全球多家科技厂商陆续发布多模态大模型,如谷歌的 PaLM-E 大模型、OpenAI 的 GPT-4 大模型以及百度的 “文心一言” 大模型。

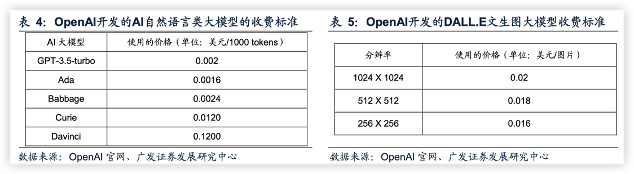

相较于自然语言类模型,多模态模型在训练阶段融合了文字、图像、三维物体等多维度数据的训练,可交互的信息类型较多,通用性得到了大大增强。分析师参考 OpenAI 和百度的 AI 大模型的收费标准后,对各行业用户用于生成类任务的成本进行了以下假设:

- 生成文本的价格为 0.003 美元/1000tokens,相当于 0.02 元人民币/1000tokens(参考汇率:1 美元=6.88 元人民币)。Tokens 是包括了单词、标点符号在内的字符,因此可以简单理解为单个文字。

- 生成图片的价格为 0.02 美元/张,相当于 0.15 元人民币/张。

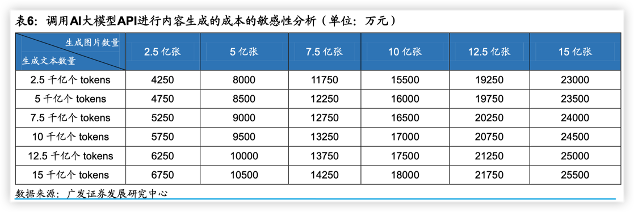

多模态大模型 API 开放后,各行业用户用于内容生成类任务的使用成本敏感性分析:基于以上假设条件,我们对各行业用户调用多模态大模型的 API 用于内容生成任务的成本做关于文本生成量和图片生成量的敏感性分析。

我们预计中短期内,基于多模态大模型的单日调用量的范围预计在 5000 万人次到 3 亿人次之间。假设每天每人生成文本内容 5 次,每次生成文本内容为 1000 个 tokens,则生成文本数量的范围预计在 2.5 千亿到 15 千亿个 tokens 之间。

假设每天每人生成图片 5 张,则生成图片的数量范围预计在 2.5 亿张-15 亿张。由此,我们测算出,各行业用户调用多模态大模型的 API 用于内容生成任务的成本如下表所示。

分析师也强调,AI 大模型技术仍处于发展早期,技术迭代的节奏和方向处于快速变化中,在 AI 算力需求测算中,也需考虑由于算法优化导致 AI 模型消耗算力成本降低的因素。考虑到软件优化带来的降本提效因素,实际硬件需求和算力成本可能较此前测算的数值较低一些。

综上,分析师指出,在暂不考虑软件层面算法优化带来的模型消耗算力成本下降的前提下,国内大模型在训练与推理阶段或将产生相当于 1.1 万台或 3.8 万台(乐观假设下)高端 AI 服务器的算力需求,以单片 A100 售价 10 万元人民币、AI 加速卡价值量占服务器整机约 70% 计算,则对应约 126 亿元(人民币)或 434 亿元增量 AI 服务器市场规模。

分析师预计,前述 AI 服务器的增量需求或将在 1-3 年的维度内逐步落地。

本文主要观点来自广发证券分析师刘雪峰(执业:S0260514030002)等发布的报告《国内 AI 大模型的训练和推理阶段算力需求测算》,有删节