Microsoft upgrades its self-developed AI chips to reduce dependence on NVIDIA, claiming to outperform Amazon's Trainium and surpass Google's TPU

Maia 200 采用台积电 3 纳米制程,是微软迄今部署的最高效推理系统、“所有超大规模云服务商中性能最高的自研芯片”,每美元性能比微软当前使用最新硬件提升 30%,在 FP4 精度下的性能是第三代亚马逊 Trainium 芯片的三倍,FP8 性能超过谷歌第七代 TPU,将支持 OpenAI 的 GPT-5.2 模型。微软已向开发者开放该芯片软件工具包预览版,计划未来向更多客户开放芯片的云服务租用,已在设计下一代 Maia 300。

微软于美东时间 26 日周一发布第二代自研人工智能(AI)芯片 Maia 200,这是微软减少对英伟达芯片依赖、更高效驱动自身服务的核心举措。这款采用台积电 3 纳米工艺制造的芯片已开始部署至爱荷华州的数据中心,随后将进驻凤凰城地区,标志着微软在自研芯片领域的重大进展。

微软云与 AI 业务负责人 Scott Guthrie 在博客文章中表示,Maia 200 是 “微软有史以来部署的最高效推理系统”,每美元性能比微软当前最新一代硬件提升 30%。这些芯片将首先供应给微软的超级智能团队用于生成数据以改进下一代 AI 模型,同时为面向企业的 Copilot 助手及包括 OpenAI 最新模型在内的 AI 服务提供算力支持。

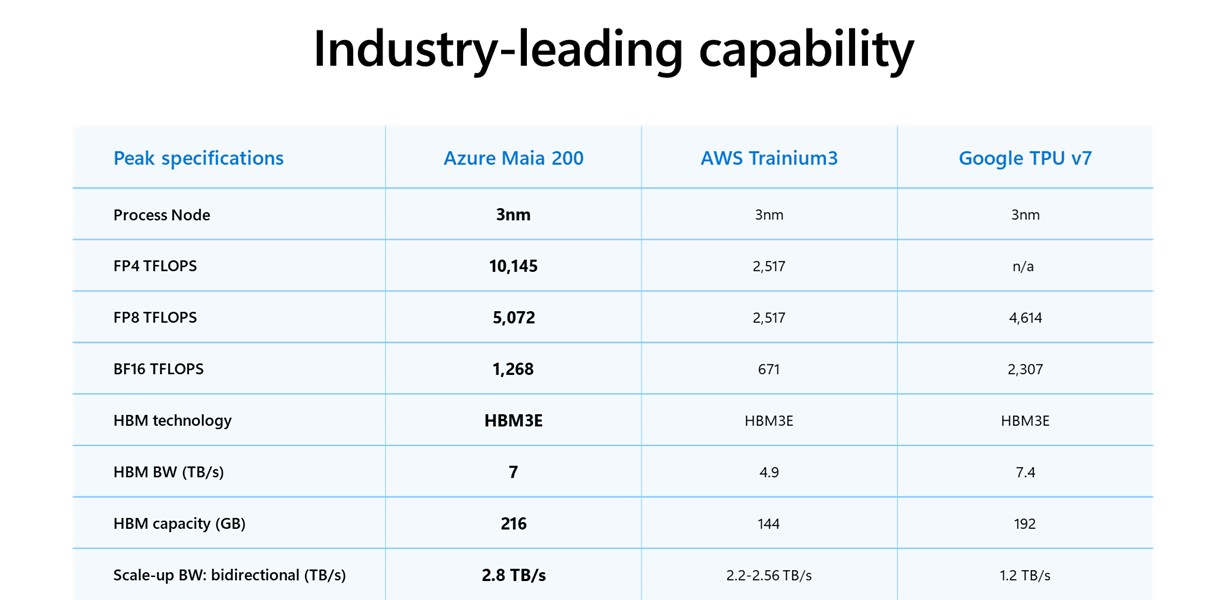

据 Scott Guthrie 披露,Maia 200 在某些性能指标上超越了谷歌和亚马逊的同类芯片。该芯片在 FP4 精度下的性能是第三代亚马逊 Trainium 芯片的三倍,FP8 性能则超过谷歌第七代 TPU。微软已向开发者、学术界和前沿 AI 实验室开放 Maia 200 软件开发工具包的预览版,并计划 “未来向更多客户开放” 该芯片的云服务租用。

这一发布凸显了科技巨头争夺 AI 算力自主权的激烈竞争。在英伟达芯片供应紧张且成本高昂的背景下,微软、亚马逊和谷歌均加快自研芯片进程,力求为云客户提供成本更低、集成更顺畅的替代方案。微软已表示正在设计 Maia 300 后续产品。

发布 Maia 200 后,美股早盘尾声时,盘初转涨的微软股价涨幅扩大到 1% 以上,临近午盘时曾涨逾 1.6%,收涨逾 0.9%,连续三个交易日收涨,刷新将近两周来收盘高位。

性能参数:超 1400 亿晶体管的推理算力

据 Scott Guthrie 在微软官方博客中介绍,Maia 200 采用台积电尖端 3 纳米工艺制造,每颗芯片包含超过 1400 亿个晶体管。该芯片专为大规模 AI 工作负载定制,在 4 位精度(FP4)下可提供超过 10 petaFLOPS 的算力,在 8 位精度(FP8)下提供超过 5 petaFLOPS 的性能,所有这些性能都在 750 瓦的芯片功耗范围内实现。

Guthrie 在博客中强调,“实际应用中,一个 Maia 200 节点可以轻松运行当今最大的模型,并为未来更大的模型留有充足空间。” 该芯片配备 216GB HBM3e 内存,带宽达 7 TB/s,以及 272MB 片上 SRAM,专门设计的 DMA 引擎和数据传输架构确保大规模模型能够快速高效地运行。

在系统层面,Maia 200 采用基于标准以太网的双层扩展网络设计。每个加速器提供 2.8 TB/s 的双向专用扩展带宽,可在最多 6144 个加速器的集群中实现可预测的高性能集体操作。每个托盘内四颗 Maia 加速器通过直连、非交换链路完全互联,在机架内和机架间使用统一的 Maia AI 传输协议,实现跨节点、跨机架的无缝扩展。

云业务关键支撑:从 Copilot 到 OpenAI 模型

Maia 200 芯片已成为微软异构 AI 基础设施的重要组成部分,将为多个模型提供服务。Scott Guthrie 的博客称,新一代 AI 加速器使微软云 Azure 在更快、更经济高效地运行 AI 模型方面占据优势。

Guthrie 披露,该芯片将支持 OpenAI 的最新 GPT-5.2 模型,为 Microsoft Foundry 和 Microsoft 365 Copilot 带来性能价格比优势。

微软超级智能团队将使用 Maia 200 进行合成数据生成和强化学习,以改进下一代内部模型。Guthrie 在博客中指出,“对于合成数据管道用例,Maia 200 的独特设计有助于加快生成和过滤高质量、特定领域数据的速度,为下游训练提供更新鲜、更有针对性的信号。”

面向商业生产力软件套件的 Microsoft 365 Copilot 附加服务以及用于在 AI 模型基础上构建应用的 Microsoft Foundry 服务都将采用这款芯片。随着 Anthropic 和 OpenAI 等生成式 AI 模型开发商以及在热门模型基础上构建 AI 代理和其他产品的公司需求激增,云服务提供商正努力提升计算能力,同时控制能耗。

Maia 200 目前已部署在微软位于爱荷华州得梅因附近的美国中部数据中心区域,随后将进驻亚利桑那州凤凰城附近的美国西部 3 区,未来还将部署到更多区域。微软已邀请开发者、学术界和 AI 实验室于周一开始使用 Maia 软件开发工具包,尽管尚不清楚 Azure 云服务用户何时能够使用运行该芯片的服务器。

减少英伟达依赖:科技巨头的芯片竞赛

微软的芯片计划启动时间晚于亚马逊和谷歌,但三家公司有着相似的目标:打造成本效益高、可无缝接入数据中心的机器,为云客户提供节省成本和其他效率优势。英伟达最新业界领先芯片的高昂成本和供应短缺,推动了寻找替代算力来源的竞争。

谷歌拥有张量处理单元 TPU,这些单元不作为芯片出售,而是通过其云服务提供计算能力。亚马逊则推出了自己的 AI 加速器芯片 Trainium,其最新版本 Trainium3 于去年 12 月发布。在每种情况下,这些自研芯片都可以分担原本分配给英伟达 GPU 的部分计算任务,从而降低整体硬件成本。

据 Scott Guthrie 在博客中披露的数据,Maia 200 在性能上明显超越竞争对手:FP4 性能是第三代亚马逊 Trainium 芯片的三倍,FP8 性能超过谷歌第七代 TPU。每颗 Maia 200 芯片配备的高带宽内存超过 AWS 第三代 Trainium AI 芯片或谷歌第七代张量处理单元(TPU)。该芯片每美元性能比微软当前部署的最新一代硬件提升 30%。

微软云与 AI 执行副总裁 Guthrie 称 Maia 200 为 “所有超大规模云服务商中性能最强的自研芯片”。值得注意的是,该芯片使用以太网电缆连接,而非 InfiniBand 标准——后者是英伟达在 2020 年收购 Mellanox 后销售的交换机所采用的标准。

快速迭代:Maia 300 已在设计中

微软表示已在设计 Maia 200 的后续产品 Maia 300。据 Scott Guthrie 在博客中透露,微软的 Maia AI 加速器项目被设计为多代迭代计划,“随着我们在全球基础设施中部署 Maia 200,我们已经在为未来几代产品进行设计,预计每一代都将不断为最重要的 AI 工作负载树立新标杆,提供更好的性能和效率。”

Maia 200 距离上一代产品 Maia 100 发布已有两年。2023 年 11 月,微软发布 Maia 100 时从未向云客户提供租用服务。Guthrie 在周一的博客文章中表示,对于新芯片,“未来将有更广泛的客户可用性”。

微软芯片开发项目的核心原则是在最终芯片可用之前尽可能验证端到端系统。一个精密的预硅环境从最早期阶段就指导了 Maia 200 架构,以高保真度模拟大语言模型的计算和通信模式。这种早期协同开发环境使微软能够在首批芯片生产之前,将芯片、网络和系统软件作为统一整体进行优化。得益于这些投入,Maia 200 芯片在首批封装零件到达后数天内就运行了 AI 模型,从首批芯片到首次数据中心机架部署的时间缩短至同类 AI 基础设施项目的不到一半。

如果内部努力遇挫,微软还有其他选择:作为与密切合作伙伴 OpenAI 交易的一部分,该公司可以获得 ChatGPT 制造商的新兴芯片设计。