Behind SanDisk's Surge: Three Catalysts Resonating, NAND Becomes a "Necessity," AI Reassesses Storage Value

黄仁勋点燃第一把火,他系统性提出 ICMS 的概念并给出了一个清晰判断:上下文正在成为 AI 的新瓶颈,而不是算力本身,这为 NAND 创造了全新应用场景;DeepSeek Engram 则在模型层面,验证了 NAND 可作为 “慢速内存” 的可行性。而 ClaudeCode 在应用层面,放大了长期存储的刚性需求。

过去三周,存储板块迎来罕见的 “完美风暴”。

闪迪股价累计涨幅超过 100%,NAND 相关标的集体上行。表面看,这是一轮典型的存储周期反弹;但如果深入拆解年初以来的技术与需求变化,会发现这更像是一场由 AI 架构演进触发的价值重估。

从英伟达在 CES 上提出全新的推理存储架构,到 DeepSeek 发布的 Engram 模型,再到 ClaudeCode 推动 “有状态 AIAgent” 加速落地,三条原本分散的技术路径,在 2026 年初同时指向同一个结论:

存储,正在从 “成本项” 转变为 AI 的 “核心生产要素”。

黄仁勋点燃第一把火:上下文成为瓶颈,存储必须被重构

AI 推理规模的失控式增长,正在逼迫算力系统重构。

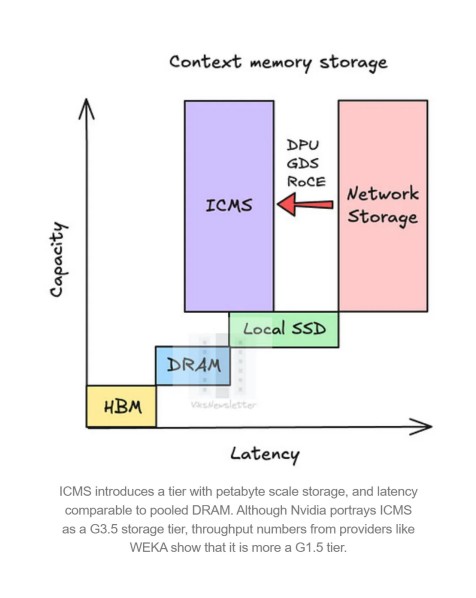

在 CES2026 上,英伟达 CEO 黄仁勋首次系统性提出 ICMS(InferenceContextMemoryStorage)的概念,并给出了一个清晰判断:上下文(Context),正在成为 AI 的新瓶颈,而不是算力本身。

随着模型上下文窗口从几十万 token 迈向 TB 级别,KVCache、上下文记忆对 HBM 的挤占已难以持续。一方面,HBM3e 单位成本远高于 NAND;另一方面,CoWoS 封装产能也对 HBM 供给形成硬约束。

英伟达的解法并非 “堆更多 GPU”,而是把上下文从 HBM 中卸载出来。

在最新发布的 DGXVeraRubinNVL72SuperPOD 架构中,除了计算与网络机架之外,英伟达首次引入了专门用于推理上下文的独立存储机架。这些机架通过 BlueFieldDPU 与 Spectrum-X 以太网接入计算体系,本质上承担的是 “工作记忆” 的角色。

从需求测算看,这一变化并非边际改动:

- 每个 SuperPOD 的新增 NAND 规模约 9.6PB

- 折算到单个 NVL72 计算机架,增量 NAND 约 1.2PB

- 若 2027 年以 SuperPOD 形态出货 10 万个 NVL72 机架,对应 120EB 的新增 NAND 需求

在一个年需求约 1.1–1.2ZB 的全球 NAND 市场中,这意味着接近 10% 的结构性新增需求。更关键的是,这部分需求直接来自 AI 基础设施,而非传统消费电子。

DeepSeek Engram:NAND 被第一次 “当作慢速内存” 使用

如果说英伟达解决的是工程架构问题,那么 DeepSeek 的 Engram 模型,则在算法层面为 NAND 正名。

Engram 的核心突破在于确定性内存访问(DeterministicLookup)。不同于 MoE 或稠密 Transformer 的动态路由,Engram 在计算开始前,就能根据输入 token 精确判断需要访问的内存片段,从而提前完成预取。

在传统模型中,只有 HBM 这种超低延迟内存,才能支撑不确定访问路径;而 Engram 的确定性预取机制,有效 “掩盖” 了 SSD 与 HBM 之间的延迟差距。

DeepSeek 的论文已经验证:

- 一个 1000 亿参数规模的嵌入表,可以完全卸载到主机内存

- 性能损失低于 3%

- 随着模型规模扩大,20–25% 的参数天然适合成为 “可卸载的静态记忆”

这意味着什么?

这意味着 NAND 不再只是 “冷数据存储”,而是第一次被系统性地纳入分层内存体系(TieredMemory),成为 AI 的 “慢速 RAM”,专门承载庞大的、低频但不可或缺的知识库。

在成本维度上,NAND 的单位价格仍显著低于 DDR 和 HBM;一旦其在模型架构中具备 “不可替代性”,其在数据中心中的战略价值将被重新定价。

摩根士丹利分析师 Shawn Kim 及其团队认为,DeepSeek 展示了一条 “少花钱多办事(Doing More With Less)” 的技术路径。这种混合架构思路,不仅在现实层面缓解了在高端 AI 算力上的资源约束,也向全球市场证明:高效的存储 - 计算协同,可能比单纯扩大算力规模更具性价比。

ClaudeCode:AI 从 “无状态” 走向 “有状态”,存储需求指数级放大

第三个催化,来自应用层。

ClaudeCode 的爆发,标志着 AI 正从 “对话工具” 向长期运行的 Agent 演进。与一次性生成文本不同,写代码的 AI 需要:

- 反复读取、修改文件

- 多轮调试与回溯

- 持续数天的会话状态

这类 AI 的本质,是拥有长期工作记忆(Long-TermWorkingMemory)的 “有状态系统”。

而这种工作记忆,显然无法长期驻留在昂贵的 GPUHBM 中。

BlueFieldDPU+NAND 的组合,恰好提供了一种成本可控的解决方案:Agent 的会话状态、历史上下文,可以常驻在 NAND 层,而不是占用算力资源。

这意味着,随着 AIAgent 渗透率提升,存储的需求函数将与推理调用次数脱钩,转而与 “状态持续时间” 挂钩——这是一种全新的增长逻辑。

为什么是闪迪?为什么是现在?

三条技术路径,在 2026 年初同时落地,构成了一个极具说服力的结论:

- 英伟达在硬件架构层面,为 NAND 创造了全新应用场景

- DeepSeek 在模型层面,验证了 NAND 可作为 “慢速内存” 的可行性

- ClaudeCode 在应用层面,放大了长期存储的刚性需求

这并非单一客户、单一产品的短期拉动,而是 AI 体系结构发生变化的信号。

在此背景下,闪迪的股价表现,不再只是 “存储周期反弹” 的映射,而是市场开始重新理解一个问题:在 AI 时代,什么才是真正的基础设施?

当 NAND 同时具备周期复苏 + 长期需求 + 结构性重估三重驱动时,其定价逻辑自然会发生跃迁。这,或许才是闪迪暴涨背后的真正原因。