AI 2.0-Networking Era Begins? "Super Ethernet Representative" Arista's Financial Report Exceeds Expectations, Surges 6% Overnight

以太网正在成为 AI 数据中心最关键的基础设施组件之一,Arista 此次上调业绩指引,被认为是对未来信心更足的表现。

本文作者:李笑寅

来源:硬 AI

在 AI 训练需求的提振下,计算机网络公司 Arista Q1 财报和业绩指引均超预期。

财报显示,Arista 一季度营收同比增长 16.3%,达到 15.71 亿美元,超出预期;公司一季度净利润同比大增 46%,达到 6.377 亿美元。

营收指引方面,该公司对 2024 年收入预期的增幅从 10%-12% 上调至 12%-14%,预计全年总营收在 16.2 亿-16.5 亿美元之间,超出华尔街普遍预测的 16.2 亿美元。

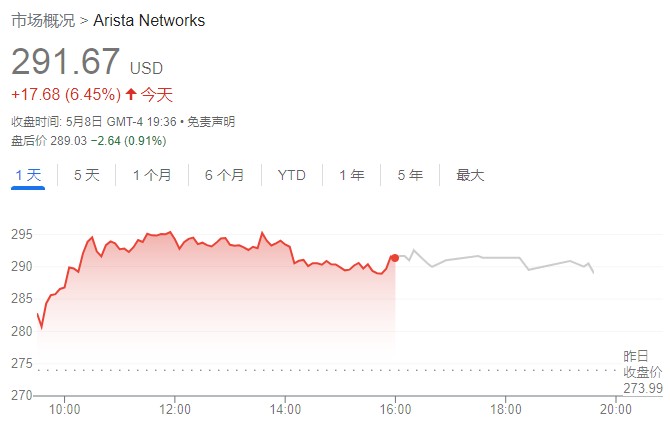

隔夜,公司股价大涨超 6%,报 291.67 美元/股。今年以来,该公司股价累计上涨近 26%。

外界分析指出,Arista 一般不会在 Q1 末就提高全年指引。因此这次上调指引,被解读为对未来信心更足。

此外,在完成了先前 20 亿美元的股票回购计划后,Arista 此次还宣布了价值 12 亿美元的股票回购计划。

AI 集群时代来临?以太网 “香” 了

Arista 于 2004 年 10 月在特拉华州注册成立,于 2008 年上市。该公司在数据驱动、客户端到云端的大型数据中心、园区和路由环境联网方面处于行业领先地位。

作为一家 to B 的网络交换器和路由器制造商,Arista 主要服务于包括微软、Meta 等在内的云服务商们。

Arista 此次在财报中表示,训练 AI 大模型对性能的高要求提振了云服务厂商对该公司硬件产品的需求。

Arista 董事长兼首席执行官 Jayshree Ullal 在财报电话会上表示,以太网正在成为 AI 数据中心最关键的基础设施组件之一。

Ullal 解释道:

“AI 应用是无法单独运行的,它们需要计算节点之间的无缝通信。”

“而随着生成式 AI 训练的发展,如今需要成千上万次单独迭代。(所以)网络拥塞导致的任何减速都会严重影响应用性能,造成效率低下的等待空耗,导致处理器性能下降 30% 甚至更多。”

简单来说,AI 工作负载无法容忍网络延迟,因为只有在所有流成功交付到 GPU 集群后才能完成作业。只要有一个链接的出现故障或延迟将限制整个 AI 的工作效率。

减少训练任务时间就需要构建横向扩展 AI 网络,从而提高 GPU 利用率。

而由后端 GPU 和 AI 加速器组成的计算节点以及 CPU 等前端节点以及存储和 IPWAN 系统之间都需要无缝通信——这就促使大规模以太网成为横向扩展 AI 训练工作负载的首选。

有 “超级以太网代表” 之称的 Arista 在该领域颇具优势。

华尔街见闻此前提及,在与竞争对手 InfiniBand 的五个 AI 网络集群竞标中,Arista 赢得了所有四个以太网。

分析指出,针对这四个集群,Arista 已经从验证过渡到中试,今年以来连接了数千个 GPU,预计可以到 2025 年生产 1 万-10 万个 GPU 节点的连接。

此前,基于其旗舰产品 7800 AI Spine,Arista 还向云服务客户构建了 2.4 万个节点的 GPU 集群,一度引起行业震动。

不仅是硬件,Arista 构建了专门的 AI 架构(NetDL),实现了结构范围的可见性,集成了网络数据和 NIC 数据,使运营商能够识别错误配置或行为异常的主机,并查明性能瓶颈。